技术文明正面临着一个存在的悖论。虽然在大型语言模型(LLM)和生成式系统的推动下,对人工智能(AI)的需求呈指数级增长,但支撑这些进步的物理基础设施正迅速逼近不可逾越的热力学极限。“摩尔定律”的主流叙事——晶体管数量和效率的持续倍增——已经开始破裂。这并非因为我们要么无法进一步微缩化,而是受制于散热和能源消耗的根本性物理约束。在这一危急关头,“热力学计算”(Thermodynamic Computing)应运而生,这是一种范式转移,承诺不仅能缓解能源危机,还将重新定义信息处理的本质。

生成式 AI 时代的“瓦特暴政”

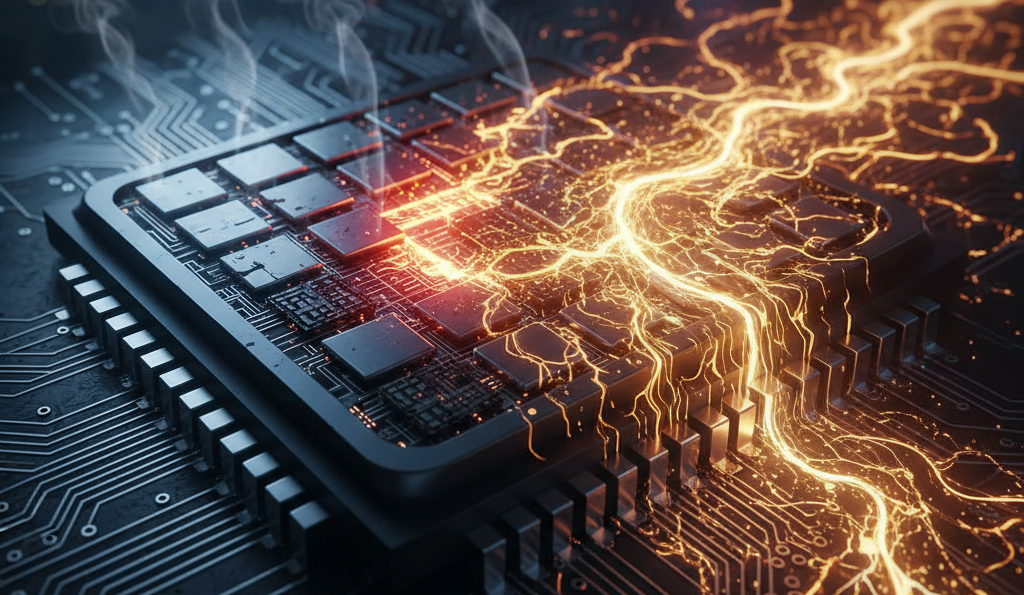

基于冯·诺依曼模型和确定性布尔逻辑的现有计算机架构,正撞上专家们所称的“能量墙”。先进 AI 模型的训练和推理几乎完全依赖于图形处理单元(GPU),例如无处不在的 NVIDIA H100。仅这一个单元的热设计功耗(TDP)就高达 700 瓦,而在 HGX H100 系统集群中,单机柜功耗更是超过 2000 瓦。这种功率密度将现代数据中心变成了需要庞大冷却基础设施的“数字熔炉”,以工业规模消耗着水和电。

宏观经济数据证实了这场危机的紧迫性。高盛预测,到本十年末,数据中心的全球电力需求将增长 165%。与此同时,国际能源署(IEA)估计,到 2026 年,数据中心的电力消耗可能会翻倍,达到 1000 TWh——这一数字相当于日本全年的总用电量。这种增长并非线性的,而是紧随 AI 模型复杂度的指数曲线,造成了一种不可持续的局面,已有 92% 的数据中心高管将电网限制视为扩容的主要障碍。

决定论的内生低效性

根本问题不仅在于算力的数量,更在于其物理“质量”。当代的数字计算是在一种“噪声抑制”的机制下运行的。为了保证一个比特毫无疑问是 0 或 1,晶体管必须在远高于电子自然“热噪声”的电压下工作。这场与熵的持续斗争——在混沌的物理介质中维持完美秩序的努力——带来了高昂的能源代价。

数字处理器中的每一个逻辑运算都涉及电容器的充放电以及电子在电阻中的移动,这会产生对计算毫无贡献的废热,代表了为强制执行决定论所必需的“摩擦”损耗。正如研究人员指出的那样,传统系统是在“支付能量”来抑制随机性。此外,内存与处理单元之间的物理分离(冯·诺依曼瓶颈)意味着大量的能量仅仅是被消耗在将数据从一处搬运到另一处,而非实际的处理过程。

热力学替代方案

面对这一困境,热力学计算提出了一种激进的逆向操作原则。与其消耗能量去对抗热噪声,不如将其作为一种计算资源加以利用。它基于这样一个前提:自然界通过向热平衡的弛豫过程(Relaxation Processes)进行高效计算。通过将计算机架构与信息的底层物理学相对齐,我们可以以比数字晶体管高出数个数量级的效率来执行复杂任务——特别是生成式 AI 所需的概率采样。

这种方法并非纯粹的理论。Extropic 和 Normal Computing 等公司已经开始制造体现这些原理的硬件,承诺效率将比现有技术高出 10,000 倍。本报告将全面分析该技术的现状、物理基础、关键参与者,以及向基于物理的计算转型所带来的地缘政治和经济影响。

物理基础:从决定论比特到随机 P-比特

要理解热力学计算所代表的创新规模,必须深入到电路运行的物理层面。传统芯片与热力学采样单元(TSU)之间的区别,不是程度上的差异,而是本体论上的类别差异。

非平衡态热力学与计算

支撑这些进展的一般理论是非平衡态统计物理学,通常被称为随机热力学。该领域提供了分析远离热平衡系统(如计算机)的工具。经典计算遵循兰道尔原理(Landauer’s Principle),该原理设定了擦除一位信息所需能量的理论下限,并将热量耗散到环境中。然而,热力学计算在不同的动力学下运行。

热力学设备被设计为在朗之万动力学(阻尼或过阻尼)下演化。这意味着物理系统会自然地“寻找”其最小能量状态。如果将数学问题编码到设备的能量景观中,系统只需通过“弛豫”到其热平衡状态即可解决问题。在这个范式中,计算不是一系列强制的逻辑步骤,而是一个自然的物理过程,类似于水滴寻找下山的捷径,或者蛋白质折叠成其最佳构型。

概率比特(p-bit)

这种新架构的基本单位是 p-bit(概率比特)。与直到被命令改变前都保持静态的数字比特不同,p-bit 在环境热噪声的驱动下,在纳秒级的时间尺度上不断地在 0 和 1 之间波动。然而,这种波动并非完全随机;可以通过控制电压对其进行偏置(Bias),使得 p-bit 例如有 80% 的时间处于状态 1,20% 的时间处于状态 0。

这种行为模仿了概率分布。通过将多个 p-bit 连接在一起,可以创建一个代表复杂联合概率分布的电路。当在任何给定时刻“读取”电路状态时,就获得了该分布的一个有效样本。这至关重要,因为现代生成式 AI 本质上就是关于概率的:预测最可能的下一个单词,或生成图像中最合理的像素。

原生采样 vs. 数字模拟

Extropic 宣称的“10,000 倍”效率优势正是源于这种结构性差异。在数字(决定论)GPU 中,从复杂分布中生成随机样本需要运行伪随机数生成器(PRNG)算法,这会消耗数千个时钟周期和数百万次晶体管转换。GPU 必须通过复杂的决定论算术来模拟偶然性。

相比之下,热力学芯片是原生生成样本的。它不模拟噪声;噪声就是计算的引擎。物理学承担了生成随机性的繁重工作,消除了为此特定任务使用复杂算术逻辑单元(ALU)的需求。本质上,这是噪声辅助的模拟计算,物理介质瞬间完成了数学运算。

表:运行特性对比

| 运行特性 | 数字计算 (GPU/CPU) | 热力学计算 (TSU) |

| 基本单位 | CMOS 晶体管(决定论开关) | p-bit(随机振荡器) |

| 与噪声的关系 | 抑制(噪声 = 错误) | 利用(噪声 = 资源/燃料) |

| 计算机制 | 顺序布尔算术 | 向最小能量状态的物理弛豫 |

| 能源消耗 | 高(对抗热力学) | 极低(顺应热力学) |

| 理想应用 | 精确计算、严密逻辑 | 概率推理、优化、生成式 AI |

Extropic:架构与不确定性策略

总部位于美国的 Extropic 已将自己定位为该技术的商业先锋。该公司由 Guillaume Verdon(前谷歌物理学家,在数字领域被称为“Beff Jezos”,有效加速主义或 e/acc 运动的领导者)和 Trevor McCourt 创立,已从理论走向了实体芯片制造。

X0 芯片:验证概率硅

Extropic 的第一个有形里程碑是 X0 芯片。这是一个测试原型,旨在验证概率电路可以使用标准半导体工艺制造并在室温下运行。与需要接近绝对零度温度的量子计算机不同,X0 利用环境热量作为熵源。

X0 包含一系列旨在从原始概率分布中生成样本的电路。其主要功能是确认 Extropic 噪声模型的准确性:证明可以将晶体管设计成以可预测和可控的方式产生“噪声”。这是一项重大成就,因为半导体行业花了 60 年时间优化工艺以消除噪声;以受控方式重新引入噪声需要对材料物理学有深刻的掌握。

XTR-0 开发平台

为了让研究人员和开发人员能够与这种新物理学互动,Extropic 推出了 XTR-0 平台。该系统不是一台独立的计算机,而是一种混合架构。在物理上,它由一块梯形主板组成,上面搭载传统的 CPU 和 FPGA,并连接到两块包含热力学 X0 芯片的子板。

XTR-0 的功能是充当桥梁。CPU 管理一般工作流和决定论逻辑,而 FPGA 充当高速转换器,向 X0 芯片发送指令和参数,并接收生成的概率样本。这种架构承认了一个务实的现实:热力学计算机不会取代数字计算机来执行运行操作系统或处理电子表格等任务。它们的角色是专用加速器,类似于 GPU 加速图形处理,但它们专门用于 AI 的概率工作负载。

Z1 芯片与规模愿景

Extropic 的最终目标不是 X0,而是未来的 Z1 芯片。预计该设备将容纳数十万或数百万个互连的 p-bit,允许在热力学基板上完全运行深层生成式 AI 模型。该公司进行的模拟表明,该芯片在执行图像或文本生成任务时,能耗比同等 GPU 低 10,000 倍。

Z1 的架构基于大规模的本地连接。与数据在芯片上长距离传输(消耗能量)的 GPU 不同,在 Extropic 的设计中,内存和计算交织在一起。P-bit 仅与其直接邻居交互,创建一个共同解决全局问题的局部交互网络。这消除了与数据移动相关的大部分能源成本。

原生算法:去噪热力学模型 (DTM)

革命性的硬件需要革命性的软件。试图在热力学芯片上运行标准深度学习算法(基于决定论矩阵乘法)将是低效的。因此,Extropic 开发了一类新的原生算法。

基于能量的模型 (EBMs)

Extropic 软件的理论基础是基于能量的模型(Energy-Based Models,EBMs)。在机器学习中,EBM 学习将低“能量”与看起来真实的数据(如猫的图像)相关联,将高能量与噪声或错误数据相关联。使用 EBM 生成数据涉及寻找低能量配置。

EBM 在理论上已经存在了几十年,但在深度神经网络面前失宠,因为在数字计算机上训练和使用它们极其缓慢。它们需要一个称为吉布斯采样(Gibbs Sampling)的过程,这在 CPU 或 GPU 上计算成本极高。然而,Extropic 的芯片可以原生且几乎瞬间执行吉布斯采样。数字硅的弱点变成了热力学硅的根本优势。

去噪热力学模型 (DTM)

Extropic 的旗舰算法是去噪热力学模型(DTM)。该模型的工作原理类似于现代扩散模型(如驱动 Midjourney 或 Stable Diffusion 的模型),即从纯噪声开始,逐步细化直到获得清晰的图像。

然而,GPU 上的扩散模型必须通过数学计算逐步去除噪声,而 DTM 则利用芯片的物理特性来执行转换。热力学硬件允许“噪声”状态遵循热力学定律物理地演变为“有序”状态(最终图像)。模拟表明,这种方法不仅速度更快,而且所需的能量减少了数个数量级,因为“去噪”过程是由系统趋向平衡的自然倾向执行的,而不是通过数万亿次浮点乘法。

竞争生态:物理计算领域的不同路径

尽管 Extropic 以其大胆的主张和赛博朋克美学吸引了媒体的关注,但它并不是该领域的唯一参与者。热力学和概率计算的竞赛包括其他成熟的竞争对手,如 Normal Computing,每家公司都有独特的技术和市场理念。

Normal Computing:通过随机性实现可靠性

Normal Computing 总部位于纽约,由前 Google Brain 和 Alphabet X 的工程师创立,他们从略微不同的角度解决问题。Extropic 专注于生成的极其速度和原始效率(加速主义),而 Normal 则非常强调关键系统中的可靠性、安全性和不确定性量化。

他们的技术基于随机处理单元(SPU)。与 Extropic 一样,他们也利用热噪声,但他们的数学框架侧重于特定的随机过程,如奥恩斯坦-乌伦贝克过程(OU Process)。OU 过程是一种均值回归随机过程,对于建模波动但倾向于回到稳定中心的系统非常有用。

Normal Computing 已经实现了重要的里程碑,例如其 CN101 芯片的“流片”(Tape-out,完成设计并交付制造)。该芯片旨在展示热力学架构在真实硅片上的可行性。他们的路线图包括未来的 CN201 和 CN301 芯片,旨在到 2027-2028 年扩展高分辨率扩散模型和视频生成。

关键区别: Extropic 似乎在以低能源成本优化最大熵和生成创造力(非常适合艺术、文本、创意构思)。Normal Computing 似乎在优化“可解释的 AI”和可靠性,利用概率硬件让 AI “知其所不知”,并在商业或工业应用中管理风险。

神经形态 vs. 热力学计算

区分热力学计算与神经形态计算(以 IBM 的 TrueNorth 或英特尔的 Loihi 芯片为代表)至关重要。神经形态计算试图经常使用决定论的数字或模拟电路来模仿大脑的生物架构(神经元、突触、电压尖峰)。

另一方面,热力学计算模仿的是大脑的物理学。生物大脑在 37°C 的潮湿、嘈杂环境中运作,利用热噪声来促进化学反应和信号传输。它不与噪声作斗争,而是利用噪声。Extropic 和 Normal Computing 认为,模仿物理学(热力学)比仅仅模仿结构(神经形态)是通往效率的更直接途径。

效率深度解析:解构“一万倍”的承诺

效率提高 10,000 倍的主张是非同寻常的,需要严格的技术审查。这个数字究竟从何而来?在生产环境中是否现实?

节约的物理学

能源节约来自三个主要来源:

- 消除数据移动: 在 GPU 中,从 VRAM 显存读取模型权重所消耗的能量比计算本身还要多。在 Extropic 的 TSU 中,模型权重物理编码在 p-bit 之间的连接中。计算发生在数据所在的地方。

- 被动计算: 在数字电路中,时钟每秒强制进行数百万次状态转换,每个周期都消耗有功电能。在热力学电路中,系统被动地向解决方案演化。能量很大程度上由环境热量(热噪声)提供,这实际上是“免费”的。

- 采样效率: 如前所述,以数字方式生成统计样本需要数千次操作。在热力学中,这是单一操作。如果一项任务需要采集数百万个样本(如在视频生成中),优势将线性累积,直到达到数个数量级。

真实能耗对比

为了更直观地理解这一点,让我们考虑 LLaMA 类模型的训练和推理。Meta 使用 16,000 个 H100 GPU 训练了 LLaMA 3。假设保守的平均功耗,能源成本高达数百吉瓦时(GWh)。在推理阶段(日常使用),如果数百万用户查询模型,累计消耗将超过训练消耗。

如果热力学芯片可以以毫瓦而不是数百瓦的功耗执行相同的推理,AI 的经济可行性将发生根本性变化。这将允许在智能手机上运行 GPT-4 级别的模型而不会在几分钟内耗尽电池,或者在农业中部署使用小电池即可运行数年的智能传感器。

局限性与警告

然而,10,000 倍这个数字源自针对该硬件优化的特定基准测试的模拟。在需要决定论逻辑、数据预处理和 CPU 通信的混合工作负载中,全球系统效率(阿姆达尔定律)将会降低。此外,模拟精度本质上是有限的。对于需要精确 64 位精度的金融计算,热力学计算并不适用。它的利基市场是概率推理,而不是精确会计。

表:效率图谱

| 效率指标 | 数字 GPU (H100) | 热力学 TSU (预计) | 理论提升倍数 |

| 每焦耳运算 | 受兰道尔极限和 CMOS 架构限制 | 仅受背景热噪声限制 | ~10^3 – 10^5 |

| 采样延迟 | 高(需顺序 PRNG 迭代) | 极低(物理上瞬间) | ~100x – 1000x |

| 电路复杂度 | 高(数百万晶体管用于控制逻辑) | 低(简单的 p-bit 和耦合) | 高面积密度 |

制造与扩展性挑战:硬件的“死亡之谷”

计算历史充满了在试图扩展时失败的有前途的技术(忆阻器、光计算、自旋电子学)。热力学计算要走出实验室面临着巨大的障碍。

工艺变异性与校准

Extropic 和 Normal Computing 面临的最大挑战是均一性。在现代芯片制造(5nm 或 3nm 节点)中,晶体管之间存在微观差异。在数字领域,这通过安全裕度来管理。在“噪声”即信号的模拟/热力学领域,晶体管尺寸的变异会改变其概率分布特征。

如果每个 p-bit 由于制造缺陷而具有略微不同的偏置,芯片将无法代表正确的概率分布。为了补偿这些变异而校准数百万个单独的 p-bit 可能需要庞大的数字控制电路,这将吞噬部分能源和空间节省。Extropic 声称已经通过鲁棒的电路设计解决了这个问题,但真正的考验将随着 Z1 芯片的大规模生产而到来。

软件生态系统集成

没有生态系统的硬件毫无用处。NVIDIA 统治 AI 不仅靠芯片,还靠 CUDA 这一软件层。为了让开发人员采用 TSU,必须抽象化物理复杂性。Extropic 发布了 Thrml,这是一个 Python 库,允许开发人员定义能量模型并在后端运行(无论是 GPU 上的模拟还是 XTR-0 上的实机)。成功将取决于这种集成与 PyTorch 和 TensorFlow 的透明程度。如果机器学习工程师必须学习统计物理学才能为芯片编程,采用率将为零。

摩尔定律的竞争

数字技术并未停滞不前。NVIDIA、AMD 和英特尔继续针对 AI 优化其架构(例如 FP8 精度、Blackwell 架构)。热力学计算正在追逐一个移动的目标。当 Z1 芯片进入商业市场时,传统 GPU 的效率也将有所提高。“10,000 倍”的优势是一个巨大的缓冲,但执行必须迅速,以免错过机会窗口。

地缘政治与经济影响

这项技术的出现所带来的影响超越了服务器机房,波及国家战略和全球 AI 经济。

AI 主权与去中心化

目前,先进 AI 是由能够资助数十亿美元数据中心并获得受限 GPU 供应的实体控制的寡头垄断。热力学计算通过大幅降低能源和硬件成本(利用更旧、更便宜的硅制造工艺,因为它们不需要最新的 3nm 光刻机即可运行),可能会使“超级智能”的获取民主化。

这将允许较小的国家或中型公司运行自己的基础模型,而不必依赖美国超大规模云厂商(微软、谷歌、亚马逊)的云服务。这是通往更大技术主权的潜在载体。

电网影响与可持续性

IEA 和各国政府对数据中心的能耗感到震惊。在爱尔兰或北弗吉尼亚等地,数据中心消耗了总电网两位数的百分比。热力学计算为这种压力提供了一个“安全阀”。如果行业将部分推理负载迁移到热力学硬件,就有可能将 AI 的增长与碳足迹的增长脱钩,从而在不阻碍技术进步的情况下实现气候目标。

加速主义哲学 (e/acc)

意识形态成分不容忽视。Extropic 首席执行官 Guillaume Verdon 是有效加速主义(e/acc)运动的核心人物,该运动主张将无限制且快速的技术进步视为宇宙的道德和热力学指令。Extropic 不仅仅是一家公司;它是这种意识形态的物理体现。他们试图最大化宇宙中熵和智能的产生。这与“减速主义”或“AI 安全主义”的愿景形成鲜明对比。Extropic 的成功将是硅谷加速主义阵营在文化和技术上的胜利。

自然智能的黎明

热力学计算代表了迄今为止弥合人工计算与自然计算之间鸿沟的最严肃尝试。七十年来,我们建造的计算机像僵化的官僚机构一样运作:遵循精确的规则,将数据归档在精确的位置,并消耗巨大的能量来确保没有任何偏差。与此同时,人脑——以及自然界本身——像爵士乐艺术家一样运作:即兴创作,利用噪声和混沌作为旋律的一部分,并以惊人的能源效率取得辉煌的成果。

Extropic 和 Normal Computing 通过 X0 和 CN101 等设备展示的技术表明,我们已经准备好采用这第二种方法。10,000 倍能源效率的承诺不仅仅是渐进式的改进;它是一个相变,将使人工智能无处不在。

然而,这条道路充满了技术风险。从数字决定论到热力学概率论的转变,不仅需要新的芯片,还需要对我们思考算法、精度和计算本质的方式进行彻底的再教育。如果 Extropic 能够成功扩展其 p-bit,并且 Normal Computing 能够证明其随机过程的安全性,那么十年后,当我们回望当前的 GPU——那些 700 瓦的硅制烤箱——时,可能会带着我们今天看待 1940 年代真空管时同样的怀旧和困惑。与热力学对抗的时代已经结束;利用热力学进行计算的时代已经开始。

后数字时代的计算版图

| 维度 | 经典数字方法 | 热力学方法 (Extropic/Normal) |

| 哲学 | 完全控制,错误抑制 | 接纳混沌,利用噪声 |

| 物理极限 | 热散热,摩尔定律 | 根本性的熵极限 |

| AI 模型 | 深度神经网络 (DNN) | 基于能量的模型 (EBM),扩散模型 |

| 硬件 | GPU, TPU (高功耗) | TSU, SPU (低功耗,被动式) |

| 未来愿景 | 城市规模的数据中心 | 无处不在、去中心化的环境智能 |